robots.txt限定些甚么屏障内容取宁静性的思索

robots.txt文件能够有用的屏障搜索系统抓与我们没有需求被抓与的页里战网站源文件,此中的益处是限定搜索系统过多的抓与没必要要的内容,削减搜索系统蜘蛛停止没必要要的网站爬觅分离,也是为了让我们的网站没必要要的内容没有正在搜索系统被支录,没有让他人搜刮到。 此中甚么样的文件会被限定抓与呢?

1、能否经由过程robots.txt去屏障静态页里,削减页里的反复抓与?

实在小我私家倡议一般网站没必要要停止静态页里的屏障,搜索系统普通会主动判定能否反复,一般网站内容其实不长短常多,普通呈现反复页里的能够性也比力低,假如是疑息站战论坛站等倡议屏障静态页里。

2、robots.txt屏障特别页里,隐公内容的屏障。

robots.txt屏障特别页里,网站隐公内容的屏障,实在关于一个网站去道,隐公内容比力易真现,正在无法式撑持的条件下,那里道的隐公是指一些没有念被传播到互联网的内容,屏障搜索系统蜘蛛制止正在互联网被众多,如:收集培训班培训材料。

3、网站特别文件夹屏障

特别文件夹普通是指,网站法式安拆文件,静态功用页里,多于的文件夹,背景功用等。

robots.txt文件的益处方才也道了,便是供给搜索系统蜘蛛看的,报告它哪些文件您没有要看,没有给您的,那是它的长处,可是robots.txt正在报告搜索系统蜘蛛的同时,也正在报告其别人,那个网站的隐公,好比:网站背景文件夹地点,信赖许多站少城市正在robots.txt上里挖写,如:Disallow:/dede/ 从那里我们能够看错该当是织梦法式,固然我们能够变动。

网站屏障的安拆文件地点,如:Disallow: /install/ 那普通是法式安拆文件的地点,便算我们背景地点变动后一样能阐发出是甚么法式做出去的。

屏障网站背景登录地点,如:Disallow: /login.asp 那样便较着报告故意人您的背景登录地点了。

屏障网站隐公内容,如:Disallow: /123.html 也只是针对搜索系统,对报酬我们借是有风险。

上里道的几面皆是出于宁静性的思索,那我们借写没有写robots.txt呢?

按照我小我私家的操纵去道,robots.txt借是要些的,究竟结果SEO许多时分离没有开他,可是关于网站宁静我们也要采纳一些须要的步伐取手腕,那我们只能正在法式的宁静性上做脚足了,但要怎样做那脚足是法式员阐扬做用的时分了,好比会员功用等。

其次,为了没有见告别人我们的隐公,那么我们能够正在robots里用“*”去躲藏我们的文件名。

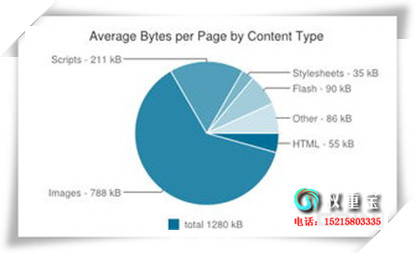

从上图能够睹,我们能够完整没有表露本人的文件名了,同时也可以对搜索系统蜘蛛停止屏障!

文章滥觞:搜索引擎优化o1/576.html

注:相干网站建立本领浏览请移步到建站教程频讲。

相关信息

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|